摘要

大脑控制着我们的一切, 它比任何一款电脑都要强大, 这一复杂的器官通过神经元一刻不停地进行着信息传递与数据分析, 甚至在我们睡觉的时候也不停歇。科学家们正试图通过了解大脑来创造一个“数字脑”, 那么, 计算机能实现人脑功能吗? 为了让计算机实现这一点, 科学家需要创建一个人工神经网络, 旨在将数字神经元连成一个类似于大脑结构的复杂网络, 同时, 研究人员需要使用数学这门通用语言来创建人工神经网络。

计算机能实现人脑功能吗?

计算机帮助我们完成一切事物, 如协助工作、娱乐、交流、看电影等等。每年, 我们都在开发出性能更好的计算机。然而, 这对人类来说远远不够, 我们梦想着拥有超越想象力的超级计算机, 能够帮助科学家在短时间内处理更多的数据。科学家们从大脑的构造方式中获得了超级计算机的灵感: 神经元在一个巨大的网络中相互连接, 电脉冲在神经元之间传输数据, 科学家们正试图创建一个数字神经网络。不同于人类大脑中的电脉冲, 在这一网络中, 数据由电子电路中的数字表示, 人工神经元连接成一个巨大的人工神经网络, 该网络可以有效地执行诸如图像识别的任务, 也许有一天, 计算机能够像人类一样思考!

大脑——人体内置计算机

你知道吗? 在短短的 1 秒内大脑可以接收数十亿个信号, 这每一秒流经大脑的数量都是空前的! 人脑如同一部车载计算机, 是有史以来最复杂的机器, 它比足球小得多, 而载有的细胞数量比银河系中的恒星还要多! 如果将身体比作一艘船, 那么大脑就是船长。人类的大脑可以非常迅速地适应全新的、不熟悉的情境, 也比世界上最高级的计算机能更快地识别物体。当你看到你的好朋友时, 大脑识别人脸的速度比蚊子扇动翅膀还要快。计算机可以识别多种复杂的模式, 但即使是当下计算能力最强的计算机也无法胜过人脑, 来自不同领域的科学家们仍在努力理解大脑的各项机制。

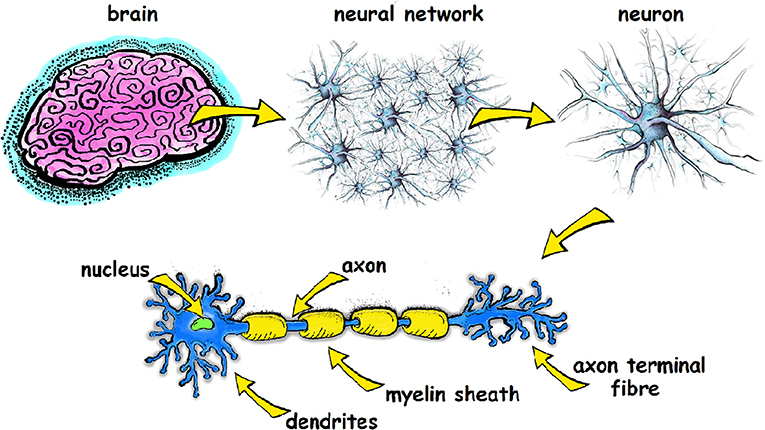

正如我们之前所提到的, 神经元是能够传导电脉冲的脑细胞, 将信息传递给其他细胞, 它由带一个细胞核的细胞体以及从细胞体延伸出来的长长的线状结构组成, 用以传输电信号。这些线状结构可分为两个部分: 一是树突, 即从其他神经元接收数据并向细胞体传导数据;二是轴突, 即从细胞体向其他神经元传递数据;树突比轴突短得多, 轴突通常有一层脂肪覆盖, 称为髓鞘;它就像包裹着电线的绝缘体, 帮助电信号流动并传递, 当两个神经元相遇并将信号从一个细胞转移到另一个细胞的地方被称为突触 (如图 1)。

- 图 1 - 大脑是由许多神经元在一个复杂的神经网络中相互连接而成的。

- 每个神经元都有一个含有细胞核的细胞体, 以及从细胞体延伸出来的部分, 称为轴突和树突。树突接收进入细胞的电信号, 而轴突则将电信号从细胞传向其他神经元。

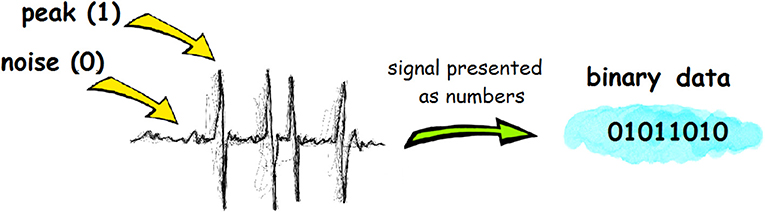

即使神经元没有向其他神经元发送电脉冲, 也总是有一个强度弱的、充当背景水平的电活动沿着神经元流动, 科学家们将这种背景电活动称为“噪声”。当使用设备来绘制神经元的电活动时,“噪声”会呈现一条略微扭曲的线;当神经元传输电信号时, 图像上会显示尖峰或是峰值 (如图 2)。由此, 我们可以认为神经元存在于两种状态中, 即“关闭” (噪声) 或“开启” (发送尖锐的电信号) [1]。这一模态可以用两个数学符号表示:“0” (表示关闭) 和“1” (表示开启)。使用 0 和 1 的语言被称为二进制语言, 这就是计算机的语言!

- 图 2 - 电脉冲可以用二进制语言表示, 即由一连串“1”和“0”数字组成。

创建人工神经网络

想象用各类形状、大小不一的管道创建一个大型的三维结构, 每一条管道都与其他不同管道相连接, 并设有一个可以“开启”与“关闭”的阀门, 最终拼接出有成百上千条管道连接的架构, 这听起来十分复杂, 不是吗? 现在, 我们把这些管道装置连接到水龙头上, 尺寸不一的管道会让水以不同的速度流动, 如果阀门关闭, 水也将停止流动。水代表在我们大脑中传输的数据, 而管道就代表神经元, 而阀门就像是连接神经元之间的突触。基于我们在上一节中提到的神经元的二进制编码, 科学家们正试图创建一个精准且有思维力的“数字大脑”, 如同我们想象的水管一样将数字神经元连接起来, 最终形成一个大型、高效、可靠的人工神经网络, 实现与数字神经元协同工作。

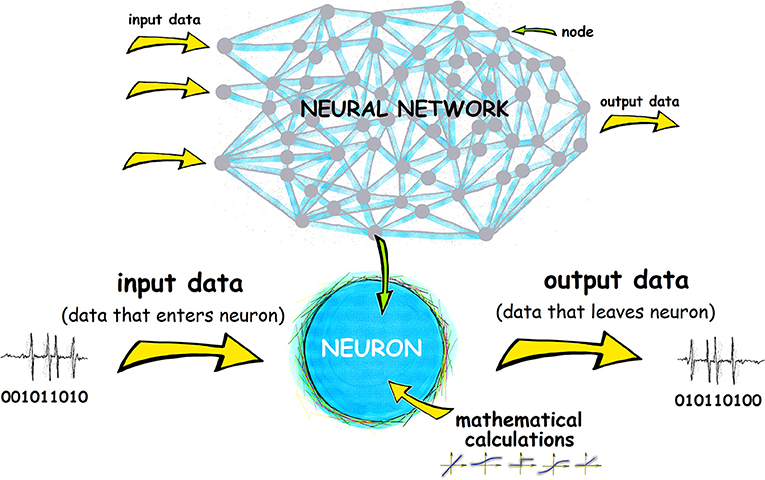

组成人工神经网络的数字神经元被称为节点, 开发人员通过编程对每一个节点赋予一个特殊的功能, 称为权重。我们可以把节点的权重比作想象中管道结构中的阀门, 即大脑中的突触;阀门负责调节传入信号的强度。让我们来想象一下, 结构中的管道通向一个水箱, 这个水箱代表了一个人工神经元, 每个阀门负责调节进入水箱的水量;从各个管道汇总而来的总水量被视作水箱的“输入”, 在人工神经网络中则被称作“信号输入”;阀门代表节点的权重, 它负责调节从外部环境和其他神经元进入到节点的信号强度, 同时, 水箱装满了大脑从外部世界接收的图像、信号、声音等信息, 即“数据输出”。

人工神经网络的每个节点有多个“输入”, 它们代表来自周边环境以及其他神经元的输入信号。当该网络处于活跃状态时, 节点通过每个“输入”接收不同的数据 (用数字表示信号), 并将数据乘以相应分配的权重, 而后节点会将所有的“输入信号”相加得到一个总数, 这就是“输出信号”。还记得上文中我们是如何解释神经元时常会收到弱强度的电噪声干扰以至于阻碍信号传输吗? 在人工神经网络中, 如果“输出信号”低于预设的阈值, 则被认为是噪声, 该节点不会将数据传递给下一层;如果数量超过了阈值, 则节点会将“输出信号”发送到下一层, 类似于当电活动足够高时, 大脑电信号通过突触传递信息的过程, 上述一切发生过程都用“1”“0” 代表的二进制语言进行记录。

受人脑启发, 为了设计出新一代超级计算机, 我们需要构建一个基于人工神经元的大型神经网络 (如图 3), 但倘若没有数学来模拟真实的神经元的运作方式, 人工神经网络的创建将是天方夜谭。

- 图 3 - 人工神经网络是由被称为节点的人工神经元组成的, 负责对“输入数据” 进行计算, 并将计算结果作为“输出数据”进行传递。

人工神经元的过去与当下

节点 (即人工神经元) 是人工神经网络的基本单位。第一个人工神经元于 1943 年由沃伦 ⋅ 麦柯克罗奇 (Warren McCulloch) 和沃特 ⋅ 彼兹 (Walter Pitts) 提出, 这一简单的人工神经元被称为感知器。数据进入感知器, 经过计算处理后离开感知器。人工神经元可以被分为好几层, 每一层负责不同的运算, 这其中最后一层叫做“输出层”, 所有其他层则均被称为“输入神经元”, 它们不起决定作用, 只负责输入信号的细节分析, 并将信息传递给下一层以开展进一步分析, 这便是人工神经网络运作的最简单形式。但是科学家们正试图建立更为复杂的网络来连接众多神经元, 与感知器不同的是, 这些人工神经元可以进行类似人脑中神经元联结等更高级的计算。

结论

目前, 人工神经网络被广泛应用于医学、工程等各个领域进行复杂的数据分析, 而且有望用于设计下一代计算机 [2], 且人工神经网络已成为游戏行业的一个不可分割的部分。我们还能利用人工神经网络做些什么呢? 比如在银行业等领域用来识别笔迹;同样, 在医学领域也能够做许多事情, 如建立人体模型以帮助医生更准确地诊断疾病, 人工神经网络可以帮助更快、更准确地分析复杂的医疗图像, 如 CT 扫描。基于神经网络的机器将能够从错误中学习, 从而自行解决许多抽象的问题。相信在不久的将来, 科学家们完全能够实现脑机接口! 这将把人类的想法切实转化为信号来更好地指导机器完成工作。或许在未来的某一天, 人类一思考, 地球便知晓!

致谢

感谢脑与心智毕生发展研究中心、发展人口神经科学研究中心对本文中文翻译的贡献。感谢陆秋宇对本文翻译及编辑的贡献;感谢左西年、张蕾对本文中文审校的贡献。

词汇表

神经元 (Neuron): ↑ 大脑神经系统中的一种细胞, 负责向其他细胞传递信号。

人工神经网络 (Artificial Neural Network): ↑ 大脑神经网络的数字化, 在节点与节点之间执行数学运算。

树突 (Dendrite): ↑ 从其他神经元接收数据并向细胞体传导数据。

轴突 (Axon): ↑ 从细胞体向其他神经元传递数据。

突触 (Synapse): ↑ 神经元信息交流的连接点, 将信息从一个神经元的冲动传到另一个神经元。

二进制语言 (Binary Language): ↑ 使用双符号系统 (0;1) 来表示数据的一种机器语言。

节点 (Node): ↑ 构成人工神经网络的数字化元素。

权重 (Weight): ↑ 一种处理信号的方式。

利益冲突声明

作者声明, 该研究是在没有任何可能被解释为潜在利益冲突的商业或财务关系的情况下进行的。

参考文献

[1] ↑ Gerstner, W., Kistler, W. M., Naud, R., and Paninski, L. 2014. Neuronal Dynamics: From Single Neurons to Networks and Models of Cognition. Cambridge: Cambridge University Press.

[2] ↑ Ghosh-Dastidar, S., and Adeli, H. 2009. Spiking neural networks. Int. J. Neural Syst. 19:295–308. doi: 10.1142/S0129065709002002